Server-Virtualisierung - Datensicherung V1.7 (c) Stor IT Back 2024

Die eigentlichen Ziele der Datensicherung in virtuellen Umgebungen sollten denen in physikalischen Systemen entsprechen. Die SLAs (Service Level Agreements) der Datensicherung werden von außen vorgegeben, von der Geschäftsführung oder aus dem Geschäftszweck oder -ziel heraus. Und diese Vorgaben ändern sich ja nicht bei der Virtualisierung. Man muss nur andere Faktoren beachten, fällt zum Beispiel ein physikalischer Server in der Virtualisierung aus, so werden viele virtuelle Maschinen betroffen sein.

Worauf kommt es jetzt bei der Datensicherung in virtuellen Umgebungen an? Man unterscheidet einige wichtige

Vorgaben:

1. Wie lange darf eine einzelne virtuellen Maschine

bzw. eine einzelne Anwendung ausfallen, wenn

a) die Daten logisch zerstört wurden (Virus, menschliches Versagen,

...)

b) der Server physisch zerstört wurde (Totalausfall, Elektronik,

bei einer VM die Image-Datei)

2. Wie lange dürfen die Anwendungen ausfallen, wenn das Rechenzentrum komplett

ausfällt (also alle VMs)?

a) bei Brand oder Wasserschaden, also echter K-Fall

b) bei punktuellem Ausfall des Serverraums

3. Welcher Datenverlust ist tragbar (entspricht der Zeit zwischen den Sicherungen),

bei

a) Ausfall der Hardware (physikalische Maschine bzw. das Storage)

b) Defekt an den logischen Daten (Virus, Löschen)

c) Totalausfall des Rechenzentrums / des Serverraumes

4. Wo müssen die Backup-Daten gelagert werden (Abstand zum Rechenzentrum,

Sicherheit, ...)?

a) Physikalische Sicherheit (Brand, Hochwasser, ...)

b) bei einem Hackerangriff

Die Anforderungen an die Wiederherstellbarkeit der Daten und Systeme ist also

gleich, nur gibt es in virtuellen Umgebungen einige neue Verfahren und Möglichkeiten (Vorteile und Vereinfachungen für den Administrator),

die bei reinen physikalischen Server nicht oder nur umständlich machbar

sind. Zum Beispiel ist die virtuelle Hardware immer gleich, auf die neue Hardware muss kaum Rücksicht genommen werden. Weiterhin sind Image-Sicherungen

der VMs sehr einfach machbar, damit ist ein Full-Restore deutlich einfacher machbar.

Der wichtigste Vorteil bei der Virtualisierung für das Betriebssystem

ist die immer gleiche (virtuelle) Hardware-Umgebung für das (virtuelle) Betriebssystem der VM.

Das Virtualisierungsprodukt bringt immer eine einheitliche Treiber-Umgebung

für die virtuelle Maschine mit, sämtliche Schnittstellen zur Hardware

sind immer gleich, egal auf welcher Hardware das System (die Virtualisierungsschicht)

im Endeffekt läuft.

Das Betriebssystem sieht also immer den gleichen Festplattencontroller,

die gleiche Netzwerkkarte und auch die sonstigen Hardware-Komponenten.

Was bringt dieser Standard jetzt für einen Vorteil?

Wird ein Restore des gesamten Betriebssystems einer VM notwendig (Full-Restore), so braucht auf eine kompatible

Hardware nicht geachtet zu werden. Dies erledigt die Virtualisierungsschicht.

Ein großer Vorteil, wenn zum Beispiel der vorhandene RAID-Controller im

Austauschserver nicht mehr verfügbar ist bzw. wäre.

Weiterhin liegen das gesamte Betriebssystem einer virtuellen Maschine, sowie

auch die gesamten Daten, auf dem Filesystem der Virtualisierung. Das ist für

die Datensicherung ein entscheidender Vorteil. Diese Datei kann (einfach) kopiert

werden und schon ist die Datensicherung erledigt. Na ja, ganz so einfach ist es

doch nicht: Das Betriebssystem und die Daten müssen natürlich vor

dem Kopieren bzw. vor der Sicherung konsistent sein. Also im einfachsten Falle

die VM herunterfahren, die Dateien kopieren und die VM wieder starten. Fertig

ist die 1 zu 1 Kopie eines gesamten (virtuellen) Servers. Es gibt auch Verfahren,

um laufende Maschinen sichern zu können, dann versetzt die Backupsoftware

das System in einen konsistenten Zustand.

Wichtig: Der Snapshot eines Hypervisors alleine macht die Daten nicht konsistent.

Ein weiterer Vorteil ist die zentrale Datenhaltung von vielen virtuellen Maschinen.

Es ist nicht mehr unbedingt notwendig auf jeder virtuellen Maschine einen eigenen

Backupclient zu installieren, die Daten liegen ja alle auf der Virtualisierungsschicht.

Dort kann direkt auf die Daten zugegriffen werden und sind die Systeme dann

auch noch konsistent bei der Sicherung, so ist eine zentrale Sicherung von einem

zentralen Punkt aus möglich. Dies spart Kosten und vereinfacht den Ablauf

der Sicherung, das Backup wird sicherer.

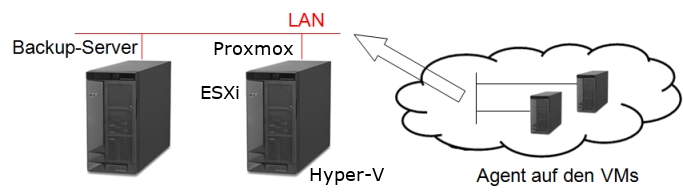

Die klassische Datensicherung wird exakt wie bei physikalischen Maschinen aufgebaut. Jeder Server bekommt seinen eigenen Backup-Client (Agent oder APM) und sichert über das (virtuelle) Netzwerk auf den Backup-Server.

Bei diesem Verfahren können Online-Agenten für Datenbanken und Anwendungen exakt wie bei

physikalischen Maschinen eingesetzt werden. Alle Vorteile des Online Backup

können genutzt werden, es steht der Point-in-Time Restore zur Verfügung

oder der Restore eines einzelnen Postfachs in einem E-Mail Server.

Dies ist dann auch die Sicherung der Wahl, wenn Systeme virtualisiert werden

sollen. Läuft das System in der virtuellen Umgebung nicht richtig, dann

kann ein Restore der Daten direkt wieder in die physikalische Maschine erfolgen.

Aber auch beim Start in die virtuelle Welt sollten nicht zwei neue Verfahren

gleichzeitig eingesetzt werden, wenigstens das Backup sollte mit erprobten Verfahren

eine Zeitlang fortgesetzt werden. Wenn die virtuelle Umgebung stabil läuft,

kann auch die Sicherung "modernisiert" oder überarbeitet werden.

Dieses Verfahren

ist also nicht unbedingt immer die beste Wahl, sie wird in virtuellen Umgebungen nur selten

verwendet.

Bei der Image Sicherung einer VM werden die gesamten Dateien, die eine virtuelle Maschine ausmachen, zusammen gesichert. Bei der Image Sicherung sind zwei Verfahren möglich, einmal die Offline-Sicherung und einmal die Online-Sicherung.

Bei der Offline-Sicherung muss nicht viel beachtet werden, die VM muss heruntergefahren

werden, ab da können die Dateien mit 100% Konsistenz gesichert (bzw. kopiert)

werden. Offline, ein klarer Nachteil, nicht jeder Server, nicht jede Anwendung kann einfach

so heruntergefahren werden. Wo dies aber möglich ist, erhält man eine

einfache und sichere Datensicherung. Die kopierten Daten lassen sich sofort

und ohne Nachbehandlung wieder als virtuelle Maschine nutzen.

Bei der Online-Sicherung läuft die virtuelle Maschine weiter. Während

der Sicherung können Dateien in der VM verändert werden und Anwendungen

und Datenbanken laufen weiter. Und das ist die eigentliche Schwierigkeit bei

diesem Verfahren. Die VM muss vor dem Start der Sicherung konsistent gemacht

werden. Das bedeutet über geeignete Verfahren (zum Beispiel VSS bei Windows)

wird das Betriebssystem und die Anwendung definiert "eingefroren"

und dann gesichert. Dieses Verfahren setzt immer eine Steuerungsmöglichkeit

direkt in der VM voraus. Befindet sich zum Beispiel eine Anwendung auf der VM,

die dies nicht ermöglicht, dann kann dieses Sicherungsverfahren nicht eingesetzt

werden.

Wichtig ist bei der Online-Sicherung immer das 100%-Funktionieren der Steuerung.

Schlägt das "Einfrieren" fehl, wird trotzdem ohne Fehlermeldung

alles gesichert. Nur kann man mit dieser Datensicherung nichts anfangen. Eine

gute Überwachung der Sicherung (und aller Steuerungsskripte und Funktionen) ist also sehr

wichtig.

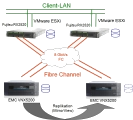

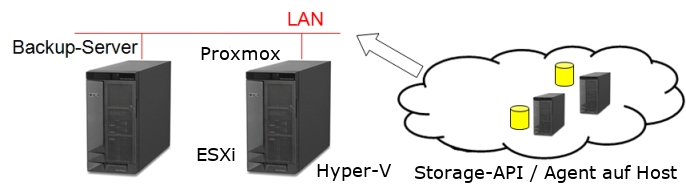

Es ist zwar eine echte Image-Sicherung einer VM (es wird ja die Datendatei der virtuellen Maschine kopiert), aber trotzdem ist meist auch der Restore einer einzelnen Datei oder sogar einer Anwendung möglich. Auch inkrementelle oder differentielle Sicherungen sind heute unproblematisch. Alle bedeutenden Backup-Software-Hersteller bieten Agenten oder APMs an, um virtuelle Maschinen zentral sichern zu können. Am besten wird in diesem Umfeld VMware mit dem ESXi Flaggschiff unterstützt. VMware bietet einen API Schnittstelle an, über die Daten auch direkt und LANfree übertragen werden können. Der Backup-Server bekommt direkt den SnapShot gemountet und kann mit maximaler Geschwindigkeit über Fibre Channel oder iSCSI sichern. Als weiteren Vorteil werden die ESXi Server bei der Sicherung nicht belastet.

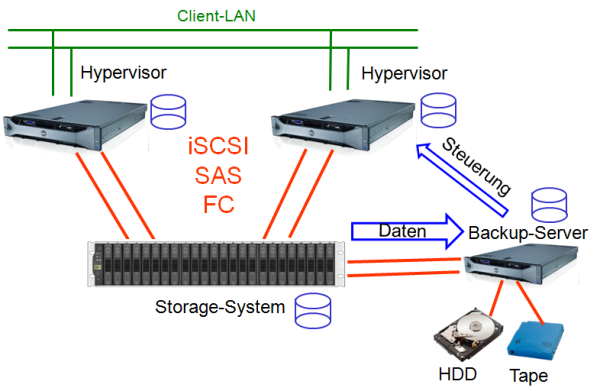

In einer virtualisierten Umgebung wird die Datensicherung häufig LANfree bzw. Serverless ausgeführt. Wie schon beschrieben greift der Backup-Server direkt auf das Storage zu. Über die API Steuerung des VMware ESXi wird zum Beispiel ein SnapShot der virtuellen Maschine erstellt und dieser SnapShot wird dann dem Backup-Server zur Verfügung gestellt. Dabei ist es eigentlich egal, wie Server und Storage miteinander verbunden sind. Ob per Fibre Channel (die klassische Enterprise-Lösung) oder per iSCSI (meist 10 Gbit/s) oder per SAS. Solange die Lösung von VMware und dem Backup-Hersteller zertifiziert ist, kann die Umgebung individuell auf die eigenen Bedürfnisse angepasst werden. In kleinen Umgebungen ist zum Beispiel SAS eine kostengünstige und hoch-performante Lösung. Wird von VMware das Essentials oder Essential Plus Paket eingesetzt, dann ist die Umgebung auf 3 Hosts begrenzt. Da viele Storage-Systeme schon 4 SAS-Kanäle anbieten, lässt sich der Backup-Server als vierter Server ideal einbinden.

Was wird jetzt aber mit dieser LANfree bzw. Serverless Lösung überhaupt erreicht? Na ja, die Alternative wäre der Transport der Daten über das LAN. Also vom Storage per SAS an den ESXi, vom ESXi über LAN zum Backup-Server und vom Backup-Server dann auf interne Platten oder ein Tape-Laufwerk. Eine sehr umständliche Lösung mit dem LAN als Bottleneck. Wenn es zum Beispiel nur Gigabit vorhanden ist, dann sind maximal 80 MB/s möglich. Nutzt man jetzt aber direkt SAS, dann sind je nach Storage-System einige hundert MB/s machbar. Damit kann das Backup-Fenster schnell um die Hälfte oder gar um zwei Drittel reduziert werden.

Aber wie läuft das jetzt ab, wenn der Backup-Server auch eine virtuelle Maschine ist? Das ist bei VMware recht einfach, der SnapShot wird der Backup-VM als

Laufwerk zur Verfügung gestellt (Hot-Add Funktion von VMware ESXi). Damit hat die Backup-VM auch einen direkten Zugriff auf die Daten, die gehen jetzt aber

noch durch den kompletten ESXi Server, also jetzt LANfree aber nicht Serverless.

Wichtig ist in allen Fällen nur die richtige Backup-Software. Einige Beispiele finden Sie in unseren Angeboten. Einmal die spezielle Lösung für

virtuelle Umgebung, Veeam Backup and Replication.

Eine Software für VMware und Hyper-V. Oder eine Enterprise-Lösung für die heterogene Sicherung,

NetVault von Quest Software. Für alle, die nicht nur eine virtuelle

Umgebungen sichern müssen, sondern auch physikalische Server und Anwendungen.

Eine sinnvolle Option ist das Kombinieren der verschiedenen Möglichkeiten: Können die Maschinen in der Nacht oder am Wochenende heruntergefahren werden, so können dort direkte Kopien auf Festplattensysteme (z.B. Network Attached Storage, NAS) angelegt werden. Von dort können im K-Fall sogar die Maschinen wieder direkt gestartet werden. Für die tägliche Sicherung (maximalen Datenverlust beachten) setzt man dann die traditionellen Agenten auf den virtuellen Maschinen ein. Zwei unabhängige Verfahren mit nahezu doppelter Sicherheit. Dies bietet sich gerade in kleineren übersichtlichen Umgebungen an.

In großen Umgebungen (über 10 virtuelle Maschinen) ist die vollständig automatisierte und überwachte Umgebung mit einem zentralisierten Werkzeug am sichersten. Diese Software sollte dann verschiedene Möglichkeiten der Sicherung unterstützen. Also eine Image- und eine Agenten-Sicherung in einem Produkt. Können die VMs nicht heruntergefahren werden, muss auf die Online-Konsistenz geachtet werden, bzw. auf die externen Schnittstellen der Backup-Anwendung zur Steuerung. Viele Hersteller spezieller Sicherungssoftware für virtuelle Umgebungen bieten neben der reinen Sicherung der VMs auch eine Replikation auf eine weitere Umgebung an. So lassen sich in einer Software Sicherung und Replikation verbinden.

Wenn nur ein Standalone ESXi gesichert werden soll, dann bietet sich das kostenfreie

ghettoVCB Skript an. Das Skript bietet die Möglichkeiten komplette virtuelle

Maschinen auf andere Datastores zu sichern. Dieses Sicherungsziel kann auch

ein NFS-Share sein, so dass elegant und einfach an einen zweiten Standort gesichert

werden kann. Dieses ghettoVCB bietet sich in größeren Umgebungen

zum Beispiel für ESXi-Server in der DMZ an, wenn diese keine direkte Verbindung

zu internen Verwaltungssystemen haben dürfen. Die VMs können direkt

auf einen NFS-Share gesichert und von dort dann in die zentrale Datensicherung

überführt werden. Damit lässt sich dann auch eine sichere Trennung

der DMZ erreichen.

Weitere Informationen zu ghettoVCB und die Grundkonfiguration finden Sie hier.

Für Virtualisierungsprojekte bieten wir die passenden Storage-Lösungen an, setzen Sie sich mit uns in Verbindung. Natürlich können Sie auch komplette Lösungen von uns bekommen. Egal zu welcher Virtualisierungssoftware, wir finden ein für Sie passendes Storage System.