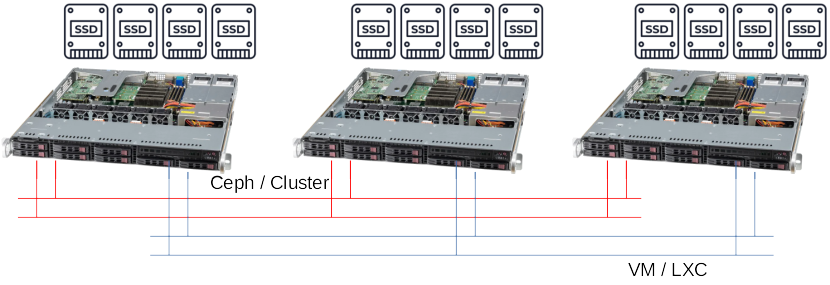

Proxmox Virtual Environment und Ceph Storage sind Open Source und basieren auf einem Debian System der aktuellen Version.

Es sind Virtualisierungen mit QEMU/KVM und LXC (Linux Containers) im Proxmox möglich. Ein HA-Cluster ist integriert

und Ceph Storage ist enthalten. Damit ist Proxmox VE mit einem kompletten Ceph Cluster mit mindestens 3 Nodes in einem Paket

erhältlich. Live bzw. Online Migration ist möglich und ein lokales Backup ist auch integriert.

Proxmox VE ist Open Source, Vorteile der Subscription ist der Zugriff auf

das Enterprise Repository und ab dem Basic Support der Support vom Hersteller. Und Support ist ein Muss in produktiven Umgebungen.

Open Source Software Lösung auf Linux-Debian-Basis

Subscription und Support über Proxmox GmbH möglich

3 Node Cluster mit Ceph, SnapShot und integrierte Backup-Lösung

Shared Storage und Cluster mit HA Funktionen

| Feature | Beschreibung |

|---|---|

| Gehäuse: | Rackmount-Server 1HE von Supermicro |

| Festplatten: | 6 x 960 GB SSD für Daten (Ceph) |

| 2 x 480 GB SSD für Proxmox-System | |

| maximal 8 SFF (2,5") Festplatten/SSD | |

| Netzwerkkarten: | 4 x 10 Gbit/s Ethernet Base-T |

| 2 x für Ceph, 2 x für VM | |

| Hauptspeicher: | 128 GB (4 x 32 GB) |

| erweiterbar, Empfehlung bei produktiven Systemen min. 256 GB | |

| Prozessor: | 2 x Intel 8-Kern CPU mit 2,8 GHz, 8 Core |

| Alternativ AMD Server Prozessoren | |

| Features: | redundante Netzteile |

| Garantie: | 36 Monate NBD Support (bis zu 5 Jahren 7x24x4) |

| Software: | Proxmox Virtual Environment (VE) |

| Lizenz: | Open Source mit Subscription (Community und Enterprise) |

| Hardware: | 1 bis n Server mit je 1 oder 2 CPUs |

| Speicherplatz: | Lokaler Speicher über ZFS, Btrfs, LVM und VLMthin |

| CIFS, iSCSI, NFS, Ceph RDB und CephFS | |

| Features: | Eingebaute asynchrone Replikation von VM-Daten |

| HA (Hochverfügbarkeit), Multimaster Cluster, Proxmox VE Cluster File System | |

| Virtualisierung mit QEMU/KVM inkl. SnapShot, PCIe pass-through, UEFI und TPM | |

| Subscription: | optional ab 110 Euro / CPU und Jahr |

|

|

Proxmox Virtual Environment (engl. / 159 kB) |

Preis auf Anfrage

Projektpreise möglich. Fordern Sie ein individuelles Angebot an!

| Bezeichnung | Enterprise Repository | Support | Preis zzgl. MwSt. |

|---|---|---|---|

| Frei | Nein | Kein Support / für Test / Entwicklung | 0,00 Euro |

| Community | Ja / Alle Features | Community Support | 110,00 Euro / Jahr / CPU |

| Basic | Ja / Alle Features | 3 Tickets / Jahr, NBD | 350,00 Euro / Jahr / CPU |

| Standard | Ja / Alle Features | 10 Tickets / Jahr, 4 Stunden BD / Remote | 520,00 Euro / Jahr / CPU |

| Premium | Ja / Alle Features | Unlimited Tickets, 2 Stunden BD / Remote | 1050,00 Euro / Jahr / CPU |

Proxmox VE - Cluster erstellen

Ceph Storage im Proxmox Cluster erstellen

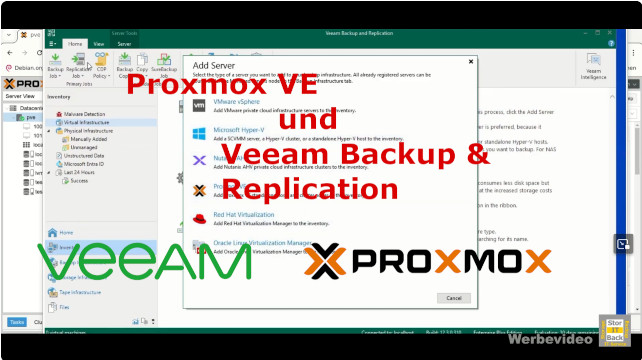

Konfiguration von Veeam Backup & Replication für Proxmox VE

In Proxmox sind verschiedene Speicher möglich. Interne Festplatten können zum Beispiel mit ZFS genutzt werden. Aber ZFS

ist kein Shared Storage. Wo liegt bei ZFS dann das Problem? Sollte ein Server ausfallen, dann können die VMs vorher per ZFS

repliziert werden. Zum Beispiel alle 15 Minuten, würde bedeuten, dass der maximale Datenverlust beim einem Failover 15 Minuten sind. Das

ist bei einem Mail-Server, einer Kunden-Verwaltung oder einem Bestell-System nicht akzeptabel.

Also ist in diesem Fall Ceph die Lösung. Die Daten der VMs sind auf allen Knoten immer exakt gleich, die VM läuft aber nur auf einem

Knoten. Sollte jetzt dieser Knoten ausfallen, dann kann die VM ohne Datenverlust auf einem anderen Knoten gestartet werden. Ein

Failover im Cluster ist also immer möglich.

Zusammenfassend ist HA eigentlich nicht ohne Shared Storage möglich. Aber auch bei der Online Migration einer VM hat Ceph große Vorteile gegenüber von ZFS.

Die Daten müssen nicht vorher kopiert werden, sie sind ja für jeden Knoten direkt erreichbar. Damit geht die Migration deutlich schneller.

Aber wie kommen jetzt die Daten von einem Server auf den anderen? Genau das übernimmt Ceph. Es werden dann alle Schreiboperationen auf die SSDs nicht nur auf dem

einen Server, sondern auf z.B. 3 Ceph Knoten gleichzeitig durchgeführt. Die Daten sind also auf 3 Knoten identisch vorhanden, sogar mehr als bei einem RAID 1. Dafür

benötigt Ceph ein "eigenes" Netzwerk. Dieses sollte leistungsfähig sein und mindestens 10 Gbit/s ermöglichen. Werden viele Daten geschrieben und gelesen und ist

damit eine hohe Last zu erwarten, dann könnte auch ein 100 Gbit/s Ethernet Netzwerk genutzt werden. Bei einem 3er Cluster kann dies auch "Direct Attached" erfolgen.

Beim Sizing des Clusters, also der Hardware, muss auf das Ceph besonders geachtet werden. Dabei muss CPU, RAM und Speicherplatz beachtet werden. CPU und RAM muss zusätzlich zu den

VMs und Containern berücksichtigt werden.

Fangen wir mit der CPU an. Ceph benötigt für Monitor-Nodes und Manager-Nodes nur geringe CPU Ressourcen. Aber der Matadata Server (MDS) benötigt einiges an CPU Leistung.

Dabei ist eine hohe Clock Rate (also die GHz) wichtig, da dies ein Single-Threaded Dienst ist. Wichtig ist bei der CPU immer auch die Virtualisierung zu beachten. Blockieren

virtuelle Maschinen die CPU, dann kann auch die Ceph-Performance leiden.

Beim RAM ist es etwas einfacher, kleinere Cluster kommen mit 32 GB gut aus, bei größeren Systemen mit vielen OSDs kann auch schon mal 128 GB genutzt werden.

Ein OSD nutzt zwischen 4 und 8 GB RAM, dieser Wert ist einstellbar. Wichtig auch beim RAM, dies kommt immer zusätzlich zur eigentlichen Virtualisierung hinzu.

Beim Speicherplatz müssen auch Reserven vorgehalten werden. Die Daten sind zwar in der Standard-Konfiguration auf allen 3 Nodes vorhanden, sollte aber eine SSD (also ein OSD)

ausfallen, so lagert Ceph die Daten auf dem Host um. Und dafür müssen Reserven vorgehalten werden. Nutzt man zum Beispiel 5 SSDs pro Server und es soll eine SSD ausfallen dürfen,

dann müssen die Daten der ausfallenden SSD noch auf die anderen SSDs passen. Und da ist Ceph ohne wenn und aber beim Schutz der Daten. Die ausgefallene SSD wird "ohne

Rücksicht" verteilt. Und eine SSD darf im Ceph höchstens zu 95% gefüllt werden. Ab diesem Moment tritt ein "Safe Modus" in Kraft und der Pool ist für die Clients nicht

mehr zugreifbar. Das muss auf jeden Fall verhindert werden. Daher sollte der Füllgrad aller OSDs überwacht werden und beim Pool auf Redundanz geachtet werden. Der Füllgrad

muss dann zum Beispiel auf 75% (der Wert kommt natürlich auf die Anzahl der OSDs / SSDs an) überwacht werden,

so das noch die ausgefallenen Daten geschrieben werden können. Proxmox bzw. das Ceph meldet ab 85% eine "nearfull" Wartung.

Tipp: Das Problem kann durch das Hinzufügen von weiteren OSDs (also SSDs) behoben werden. Ceph verteilt die Daten dann neu.

Erst einmal, was fehlt denn noch zum Betrieb dieses Clusters? Wichtig ist die Netzwerkinfrastruktur, also die LAN Switches. In den Servern

sind 4 x 10 Gbit/s in RJ45 vorhanden. Damit bieten sich dann auch RJ45 10 Gbit/s Switche an. Es sollten auf jeden Fall 2 Stück sein, besser noch 4.

Die 2 Stück wegen der Redundanz. Sollte ein Switch ausfallen, so kann sowohl der Ceph-Verkehr, wie auch die Clients noch kommunizieren. Auch der Cluster

kann weiterhin den Zustand austauschen. Würde alles über nur einen Switch laufen, dann fällt der gesamt Cluster im Fehlerfalle aus.

Aber warum 4 Stück? Dann könnte man Ceph und VMs bzw. Clients trennen. Das ist auch bei 2 Switches über VLANs möglich, aber die 4 sichern noch zusätzlich ab.

Welche Hersteller bzw. welche Switches sollen es denn sein? Wichtig ist die Anzahl der Ports, damit nicht nur der Cluster, sondern auch die Clients noch verbunden

werden können. Beim Hersteller ist es nahezu egal, managebar sollte er sein und Funktionen wie VLAN und evtl. QoS bieten. Wir beraten Sie da gerne.

Mehr Speicherplatz für virtuelle Maschinen und Container ist kein Problem. Größere SSDs und/oder mehr Slots in den Servern sollte man dann einplanen. Wird deutlich mehr

Speicherplatz benötigt, so sollten Server mit 2 Höheneinheiten und zum Beispiel 24 SSD/Festplatten-Slots verwendet werden.

Bei RAM und CPU kann ganz normal ausgestattet bzw. erweitert werden. Es kann auch erst Mal mit nur einer CPU pro Node gestartet werden, deutlich weniger RAM ist aber nicht

zu empfehlen. Weil auch das Ceph benötigt RAM, aber auch CPU.

Kann man mit dem Ceph auch drehende Platten nutzen? Technisch ist das möglich, die Performance ist aber deutlich eingeschränkt. Für die normalen Unternehmensanwendungen

sollten schon SSDs (also Flash-Only) genutzt werden. Werden zum Beispiel große Datenmengen für ein Archiv benötigt, also mit wenig Anspruch an das Speichersystem,

dann könnte zum Beispiel ein NAS über iSCSI oder NFS angebunden werden. Damit nutzen dann Datenbanken und Anwendungen das Ceph als All-Flash und

die großen Daten liegen dann auf einem externen Storage (z.B. einem NAS).

Auf dem Proxmox Cluster können virtuelle Maschinen neu erstellt oder von anderen Umgebungen migriert werden. Mögliche Beispiele von der Neuerstellung bis zur Migration stellen wir in Videos vor.

Linux Server als virtuelle Maschine neu erstellen

Windows Server 2022 als virtuelle Maschine neu erstellen

Wie bei allen unseren Systemen erhalten Sie kostenfrei einen 24 Stunden Test

der Systeme und eine Grundkonfiguration. In diesem Paket geht die Konfiguration aber noch weiter.

Der Server wird für die Proxmox-Installation vorbereitet, inklusive der notwendigen Netzwerkkonfiguration

und dem internen Speicher. Sie müssen den Server bzw. die zwei Server nur verkabeln (Netzwerk und Strom) und einschalten.

Auch eine Installation vor Ort ist möglich, ebenso eine Schulung, egal ob remote oder vor Ort. Wir unterstützen Sie auch

bei der Migration ihrer virtuellen Maschinen, egal ob von VMware oder Hyper-V. Fragen Sie uns!

Weitere Informationen erhalten Sie hier. Oder setzten Sie sich mit unserem Vertrieb in Verbindung, entweder per E-Mail oder unter Telefon 04185 / 707 85 0.

| Telefon: | 04185 / 707 85 0 |

vCard der Stor IT Back GmbH & Co. KG: |

|

| Fax: | 04185 / 707 59 43 | ||

| E-Mail: | info@storitback.de |